Der große Energieverbrauch Künstlicher Intelligenz

Megawatts des maschinellen Lernens

EINE N3XTCODER-Reihe

Implementierung von KI für soziale Innovation

Willkommen zur N3xtcoder-Serie über die Implementierung von KI für soziale Innovation.

In dieser Serie untersuchen wir, wie Künstliche Intelligenz zum Nutzen der Gesellschaft und unseres Planeten eingesetzt werden kann - insbesondere der praktische Einsatz von KI für Projekte der sozialen Innovation.

In dieser Folge befassen wir uns mit dem Energieverbrauch von KI, dem Carbon Footprint und den Möglichkeiten, diesen zu optimieren.

KI-Technologien machen rasante Fortschritte, nicht nur in Bezug auf ihre Fähigkeiten, sondern auch in Bezug auf ihre weit verbreitete Anwendung in verschiedenen Geschäftsbereichen. Aber KI-Modelle verbrauchen auch wesentlich mehr Energie als herkömmliche Computer, so dass die Notwendigkeit, ihren Energieverbrauch zu optimieren, von entscheidender Bedeutung ist.

Fragen, die wir gerne beantworten möchten:

- Warum braucht KI so viel Energie? Wir geben einen kurzen Überblick darüber, warum KI so energie- und ressourcenintensiv ist.

- Was können KI-Entwickler tun? Wir gehen der Frage nach, wie Entwickler den Energieverbrauch bei der Programmierung von KI und bei der Einrichtung von KI-Systemen reduzieren können.

- Was kann KI leisten? Wir untersuchen, wie KI-Anwendungen und -Tools ebenfalls dazu beitragen können, den Energieverbrauch von KI und anderen digitalen Systemen zu senken.

- Was können Regierungen und Regulierungsbehörden tun? Schließlich gehen wir der Frage nach, was politische Entscheidungsträger tun können, um den Energieverbrauch von KI zu senken.

Warum braucht KI so viel Energie?

Die großen Sprünge, die wir in letzter Zeit bei KI-Modellen gesehen haben, waren oft das Ergebnis der Verwendung immer größerer Datensätze auf immer größeren Hardware-Infrastrukturen, die alle mehr Energie für das Training benötigen. Darüber hinaus bedeutet die exponentielle Zunahme der Popularität von KI-Tools, dass der Laufzeitbedarf, d. h. die für den Betrieb einiger Modelle in der Produktion erforderliche Energie, ebenfalls in die Höhe geschnellt ist.

Die meisten KI-Unternehmen halten die genaue Energiemenge, die sie verbrauchen, unter Verschluss (https://www.theguardian.com/technology/2023/jun/08/artificial-intelligence-industry-boom-environment-toll). Das könnte daran liegen, dass das Thema nicht so sehr im Mittelpunkt steht, oder es könnte daran liegen, dass sie sich scheuen, genaue Zahlen zu veröffentlichen, die unerwünschte Aufmerksamkeit erregen könnten. Es könnte aber auch einfach daran liegen, dass es keinen einheitlichen Ansatz für die Berechnung gibt und dass es schwierig ist, alle relevanten Daten zu sammeln.

Bei der Betrachtung der Energiekosten der KI sollten wir auch den Kohlenstoff-Fußabdruck der KI betrachten, der natürlich eng mit dem Energieverbrauch verbunden ist. Der beste Ansatz zur Messung der Kohlenstoffemissionen eines komplexen Systems wie eines KI-Modells ist eine Lebenszyklusanalyse, d. h. die Messung der Kohlenstoffemissionen von den Materialien und Prozessen, die für die Herstellung des Systems erforderlich sind, über die Kohlenstoffemissionen des Systems während der Nutzung bis hin zu den Kohlenstoffemissionen, die am Ende der Lebensdauer des Systems entstehen.

Ein Standard-Kohlenstoffbericht misst "Scope 1, 2 und 3 Emissionen":

- Scope 1 sind die Emissionen, die durch den Betrieb des Systems selbst entstehen. Bei einem KI-System sind diese wahrscheinlich recht gering, auch wenn einige der Emissionen des Büros und der Mitarbeiter des Unternehmens hier erfasst werden.

- Scope 2 sind die Kohlenstoffemissionen, die direkt mit dem Energieverbrauch des Systems zusammenhängen.

- Scope-3-Emissionen sind alle anderen Emissionen, einschließlich der Emissionen von Rohstoffen und der Herstellung der Hardware über die Emissionen der Menschen, die das System nutzen, bis hin zur Entsorgung am Ende der Lebensdauer.

Bei einem KI-Modell sind die Scope-3-Emissionen wahrscheinlich sehr hoch, da sie viele Tausende von hochmodernen Grafikprozessoren erfordern, deren Herstellung sehr kohlenstoffintensiv ist. Leider veröffentlichen die großen GPU-Hersteller wie Nvidia keine Daten zum CO2-Fußabdruck, und solange sie dies nicht tun, sind alle Scope-3-Messungen von KI-Modellen grobe Schätzungen.

Das mag erklären, warum die Berechnungen des CO2-Fußabdrucks für KI häufig mit dem Training des Modells beginnen, obwohl in einigen Fällen auch der Energie-Fußabdruck der Infrastruktur gemessen wird, die Echtzeit-Inferenz, Vorhersage oder andere Operationen in der Produktion unterstützt.

Was ist über den Energieverbrauch der KI-Trainingsphase bekannt?

[Es wird davon ausgegangen, dass GPT 4.0 mit diesen Daten unter Verwendung von etwa 25.000 GPUs trainiert wurde (https://towardsdatascience.com/the-carbon-footprint-of-gpt-4-d6c676eb21ae), bei denen es sich um die modernsten und energieintensivsten verfügbaren Mikroprozessoren handelt. Dieses Training würde eine konstante Stromzufuhr von etwa 20 Megawatt für bis zu 100 Tage erfordern. Das entspricht in etwa den jährlichen Emissionen von 193 durchschnittlichen benzinbetriebenen Autos oder von 2000 Barrel Öl (https://www.epa.gov/energy/greenhouse-gas-equivalencies-calculator#results).

Wie hoch ist der Energieverbrauch von KI in der Produktion?

Sobald das Modell vollständig trainiert ist, verbraucht es, je nach Modell, wahrscheinlich fast genauso viel Strom, um aus Aufforderungen Antworten zu generieren, was oft als Inferenz bezeichnet wird. Meta schreibt etwa ein Drittel seines internen End-to-End-Kohlenstoffverbrauchs für maschinelles Lernen (ML) der Modellinferenz zu, während der Rest auf Datenmanagement, Speicherung und Training entfällt (https://arxiv.org/pdf/2111.00364.pdf); eine Studie von Google aus dem Jahr 2022 schreibt 60 Prozent seines ML-Energieverbrauchs der Inferenz zu, verglichen mit 40 Prozent für das Training. (https://arxiv.org/pdf/2204.05149.pdf)

Um dies ins rechte Licht zu rücken, wird für die Erstellung eines einzigen KI-Bildes schätzungsweise so viel Energie benötigt wie für das vollständige Aufladen eines Smartphones. Die Texterstellung hingegen verbraucht viel weniger Energie. Im Durchschnitt wird für eine Abfrage etwa 1/4000stel einer Smartphone-Ladung benötigt (oder anders ausgedrückt: 1000 Abfragen erfordern 16 % des Energiebedarfs einer vollen Smartphone-Akkuladung) (https://arxiv.org/pdf/2311.16863.pdf)

Aufgabenspezifische KI-Modelle vs. Mehrzweck-KI-Modelle

KI kann entweder auf eine bestimmte Aufgabe oder auf eine Vielzahl verschiedener Aufgaben trainiert werden. Die Bandbreite der Aufgaben, die ein Modell lösen kann, seine Aufgabenvielfalt, hat Auswirkungen auf den Energieverbrauch des Modells. Während Modelle mit vielfältigen Fähigkeiten in Bezug auf ihren Gesamttrainingsaufwand effektiver zu sein scheinen, erfordert die Breite ihrer Fähigkeiten in der Inferenzphase im Durchschnitt mehr Energie als die von aufgabenspezifischen Modellen.

Wie ist der aktuelle Stand des Energieverbrauchs von KI?

Während die weltweite Energieproduktion nur sehr langsam zunimmt - etwa 1 bis 2 Prozent pro Jahr - steigt der Energieverbrauch von maschinellem Lernen und KI in alarmierendem Tempo. Eine Studie zeigt, dass bei der derzeitigen Wachstumsrate die KI bis etwa 2047 die gesamte verfügbare Energie verbrauchen würde. Das ist ganz klar nicht nachhaltig. Darüber hinaus ist dieser Energieverbrauch nicht billig, so dass die Verringerung des Energieverbrauchs der KI einer der glücklichen Momente ist, in denen Kostensenkung und Kohlenstoffeinsparung Hand in Hand gehen. Dies ist neben der Nachhaltigkeit ein weiterer starker Anreiz, den KI-Energieverbrauch zu optimieren.

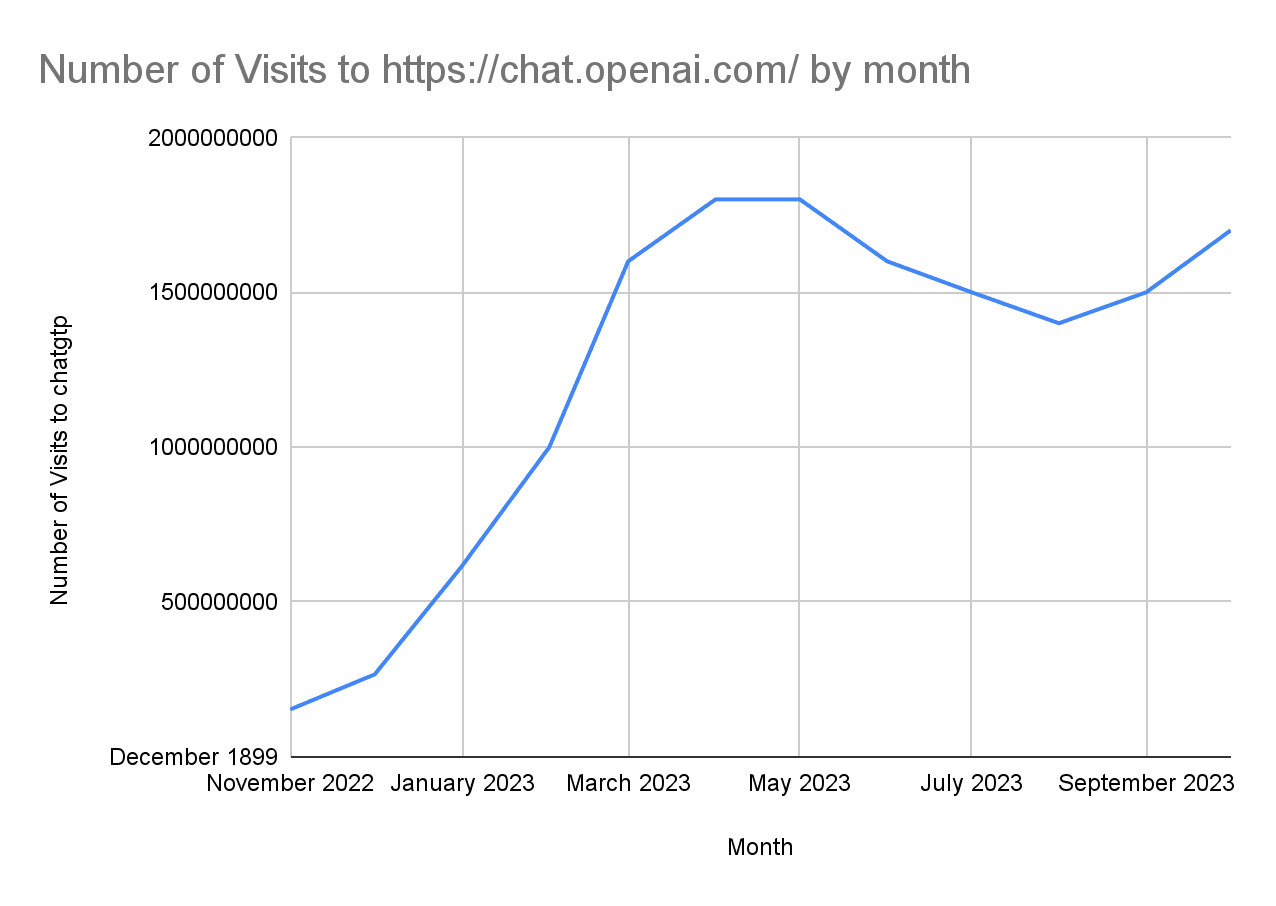

Quelle: Similarweb

Warum steigt der Energieverbrauch so schnell?

Kurz gesagt können wir das, was im Deutschen als "Goldgräberstimmung" oder "Goldrausch-Effekt" bezeichnet wird, für die vielen KI-Investitionen verantwortlich machen.

"Der Rechenbedarf neuronaler Netze ist unersättlich", sagt Ian Bratt, Fellow und Senior Director of Technology bei Arm. "Je größer das Netzwerk, desto besser die Ergebnisse und desto mehr Probleme kann man lösen. Der Energieverbrauch ist proportional zur Größe des Netzwerks. Daher ist eine energieeffiziente Inferenz absolut notwendig, um die Einführung von immer ausgefeilteren neuronalen Netzen und erweiterten Anwendungsfällen, wie Echtzeit-Sprach- und Bildverarbeitungsanwendungen, zu ermöglichen."

Dieses "Wettrüsten" um Rechenleistung ist nicht nur schlecht für den Planeten, sondern erhöht auch die Hürden für eine Teilnahme immer weiter. Kleine und mittelgroße Akteure können auf dem Markt einfach nicht mit den Ressourcen konkurrieren, die den großen Fischen, wie OpenAI und Google, zur Verfügung stehen.

Wie können wir diese Situation wieder in den Griff bekommen? "Wir haben vergessen, dass der Motor der Innovation in den letzten 100 Jahren die Effizienz war", sagt Steve Teig, CEO von Perceive. "Das war der Grund für Moore's Law. Wir befinden uns jetzt in einem Zeitalter der Anti-Effizienz." (https://semiengineering.com/ai-power-consumption-exploding/)

Sobald die KI in der Lage ist, aus weniger Rechenleistung das Beste herauszuholen, werden hoffentlich die Hürden für weitere Durchbrüche sinken und damit auch der Kohlenstoff-Fußabdruck. Aber wird Effizienz das Problem lösen? Möglicherweise nicht, wenn wir das Jevons-Paradoxon berücksichtigen, das manchmal auch als "Rebound-Effekt" bezeichnet wird. William Jevons war ein Wirtschaftswissenschaftler des 19. Jahrhunderts, der feststellte, dass bei einer Verbesserung der Effizienz einer Maschine oder eines Prozesses der Gesamtenergieverbrauch oft nicht gesenkt wurde, sondern der Energieverbrauch gleich blieb und die Gesamtproduktion stieg. Dieser Effekt ist überall zu beobachten, nicht zuletzt in den Rechenzentren, die zwar immer energieeffizienter werden, aber am Ende immer mehr Daten speichern und noch mehr Energie benötigen.

Die Lehre aus dem Jevons'schen Paradoxon lautet: Wenn wir den Gesamtenergieverbrauch senken wollen, müssen wir ein System ganzheitlicher betrachten und dürfen uns nicht nur auf die Effizienz konzentrieren.

Wenn dies das Ziel wäre, könnte ein wirklich energieeffizientes KI-Ökosystem nicht nur mehr Energie sparen, sondern auch eine breitere Innovation fördern, indem es KI zugänglicher macht. Eine Senkung des Energiebedarfs der KI-Nutzung kann auch dazu führen, dass KI-Technologien einem breiteren Publikum zugänglich gemacht werden, indem beispielsweise kleinere Unternehmen und Forschungsinitiativen in die Lage versetzt werden, sich an der Entwicklung und Einführung von KI-Lösungen zu beteiligen. Dies kann wiederum ein breiteres Spektrum an Innovationen anregen.

Lesen Sie weiter in Teil 2: Was können AI und AI Entwickler tun, um den CO2-Fußabdruck der KI zu verringern